すべてにピントを合わせる カメラレンズは、これまで不可能だった「手前から奥まで同時にシャープに写す」ことを目指す新技術です。従来のレンズは1枚の平面にしかピントを合わせられず、手前か奥のどちらかを犠牲にする必要がありました。絞りを小さくしても、暗さや回折による解像度低下が避けられません。

近年は、焦点面そのものを自由に設計する発想が生まれ、2枚のキュービックレンズで焦点を制御するローマン/アルバレスレンズや、光学とアルゴリズムを融合したコンピュテーショナルレンズの研究が進んでいます。さらに、空間的CDAFやPDAFなど、領域ごとに最適なピントを導く技術も登場しました。

この進化により、写真だけでなく顕微鏡観察、自動運転、監視カメラなどへの応用も期待されています。まだ光量ロスや専用センサーなどの課題はありますが、実用化が近づく次世代のレンズ技術として注目されています。

- すべてにピントを合わせる カメラレンズの基本的な仕組み

- 従来のボケや絞り、フォーカススタックとの違い

- 新しいコンピュテーショナルレンズ研究の内容と応用分野

- 実用化に向けた課題と今後の展望

- すべてにピントを合わせる カメラレンズ入門

- すべてにピントを合わせる カメラレンズ研究の最前線

- 発想の転換:「1つの焦点面」ではなく「好きな形のフォーカル面」を作る ローマン/アルバレスレンズとは?2枚のキュービックレンズで焦点を変える仕組み

- 光学 × アルゴリズムのハイブリッド「コンピュテーショナルレンズ」ととは

- 各エリアごとに最適なピントを探す「空間的なコントラストAF(CDAF)」 デュアルピクセルを活用して一気に深度マップを推定する「空間的PDAF」

- オプティカルに「オールインフォーカス」を実現するメリットと制約

- 写真だけじゃない:顕微鏡・自動運転・監視カメラへの応用可能性

- 背景だけボカす/細いワイヤだけ消す──自由自在なボケ表現のデモ例 なぜまだ製品化されていないのか?光量ロス・光学設計・専用センサーの課題

- すべてにピントを合わせる カメラレンズとレンズ設計の新しいカテゴリとしての意義と、今後の研究・実用化の展望

すべてにピントを合わせる カメラレンズ入門

●このセクションで扱うトピック

- すべてにピントが合う?「夢のレンズ」がついに現実に近づいた

- そもそも従来のレンズは「1枚の平面」にしかピントを合わせられない

- 絞れば全部にピントが合う?それでも限界があった理由(ボケ・暗さ・回折)

- これまでの手法(小絞り・フォーカススタック・ライトフィールド)との違い

すべてにピントが合う?「夢のレンズ」がついに現実に近づいた

風景の手前にある花から、遠くの山並みまで、すべてにピントが合った写真を一枚で撮りたいという願いは、フィルム時代から多くの写真家や研究者が追いかけてきたテーマです。

背景を大きくぼかす浅い被写界深度の表現が注目されがちですが、「記録」や「認識」を目的とした撮影では、シーン全体をくっきり写したいというニーズも根強く存在します。

この理想をかなえようとする試みは、単に絞り値を上げて被写界深度を深くする、といったレベルにとどまりません。

最新の研究では、レンズそのものの仕組みを再設計し、「光学系+アルゴリズム」の組み合わせで、従来の制約を根本から乗り越えようとしています。

カーネギーメロン大学の研究チームは、シーン全体を一度にくっきり描き出すための新しいコンピュテーショナルレンズを開発し、Spatially-Varying Autofocus(空間的オートフォーカス)という枠組みとして提案しています。これは、従来は不可能だった「場面の各部分ごとに異なる深さへピントを合わせる」という動作を、光学的に実現しようとするものです。

ここでのポイントは、画像処理でボケを補正するのではなく、最初からセンサー面に全てがシャープな像として結像するように光学系を組んでいる点にあります。

この仕組みによって、従来型の撮影で避けにくかった次のような問題を、大きく抑えられる可能性があります。

- 一部分だけピンボケになって、被写体のディテール情報が失われる

- 後処理で無理にシャープネスを上げると、ノイズや偽輪郭が増えてしまう

Spatially-Varying Autofocusの研究では、可変焦点光学系と空間的なオートフォーカスアルゴリズムを組み合わせることで、以下のような特徴を示しています。

- 1枚目の画像からシーンの奥行き構造を推定し、2枚目の撮影時にはその情報を使ってほぼ全域を光学的に合焦させる

- 小絞り撮影のように回折ボケを増やすことなく、広い被写界深度と高い解像感を両立しやすい

- 動きのあるシーンに対しても、デュアルピクセルセンサーなどを活用することで、毎秒20フレームを超える追従性を実現できると報告されている

この研究は、ICCV 2025(International Conference on Computer Vision)でBest Paper Honorable Mention(上位2本)を受賞しており、コンピュータビジョンと計算イメージングの分野で高い評価を受けています(出典:Carnegie Mellon University Electrical and Computer Engineering「The Perfect Shot」)。

完全な実用レベルの製品として、一般向けのカメラやスマートフォンに搭載されるには、まだ光学設計の最適化や小型化、コストなど多くの課題があります。

それでも、すべてにピントを合わせる カメラレンズというアイデアそのものが、理論上の構想を超えて、研究用のプロトタイプとして実際に動作している段階に到達していることは、大きな転換点といえます。

将来的には、「深度情報を含んだ認識用カメラ」「顕微鏡や自動運転に特化した視覚センサー」「撮影後にフォーカス面を自由にデザインできる撮影システム」など、さまざまな応用が視野に入っています。

いまはまだ実験室レベルの技術ですが、写真表現だけでなく、機械視覚や計測の世界をも変える基盤技術へと育っていく可能性があります。

そもそも従来のレンズは「1枚の平面」にしかピントを合わせられない

従来のカメラレンズは、光学設計の原理上、一度に正確なピントを合わせられるのは「ある一枚の平面」だけです。

この平面はフォーカルプレーン(焦点面)と呼ばれ、被写体がその面上にあれば、センサー上にもっともシャープな像が結ばれます。逆に、その平面より手前や奥にある被写体は、結像位置がずれてしまい、センサー上ではぼけとして写ります。

被写界深度という概念は、この「ぼけ」が許容できる範囲をどこまで広げるか、という考え方に基づいています。

一般的なレンズでは、フォーカスリングを回すことでレンズとセンサーの距離を調整し、ある特定の距離の被写体だけが最もシャープになるように設定します。

その前後の距離にいる被写体は、「許容錯乱円」の範囲内に収まっている限り、肉眼ではピントが合っているように見えますが、厳密にはすでにぼけが始まっています。

この構造には、いくつかの避けがたい制約があります。

- ピントが合うのは、基本的に一枚の平面状に並んだ被写体だけである

- 手前の被写体と奥の被写体に大きな距離差があるシーンでは、どちらか一方、あるいは中間距離に妥協する必要がある

- ボケの量や被写界深度は、絞り値(F値)・焦点距離・被写体距離などに強く依存し、撮影条件の自由度を縛ってしまう

例えば、テーブルの上に近接物体があり、その奥に窓辺の風景が広がるようなシーンを思い浮かべると分かりやすくなります。

従来のレンズでは、手前の被写体にピントを合わせれば背景は大きくぼけ、背景にピントを合わせれば手前の被写体がぼけます。

絞りを絞ることで両者をある程度同時に見せることはできますが、前述のように暗さや回折ボケ、シャッタースピードなど、別の制約が表面化します。

ここで、すべてにピントを合わせる カメラレンズの研究が目指しているのは、この「1枚の平面しか合焦できない」という前提そのものを崩すことです。

レンズ側の性質を動的かつ空間的に制御し、センサー上の場所ごとに異なる距離にピントを合わせられるようにすることで、従来のレンズにはなかったフォーカスの自由度を得ようとしています。

具体的には、次のような方向性が探られています。

- フォーカルプレーンを平面ではなく、被写体の形に沿った曲面として設計する

- 画面の左側は手前にフォーカス、右側は奥にフォーカスといった、位置依存のフォーカス制御を行う

- シーンの深度マップに合わせて、レンズの焦点特性をリアルタイムに書き換える

このようなアプローチにより、「被写体の配置にカメラを合わせる」のではなく、「カメラのフォーカス面を被写体の三次元構造に合わせる」という、新しい発想が実現に近づいています。

従来レンズの制約を知るほどに、この研究がどれほど大胆な挑戦であるかが見えやすくなるはずです。

絞れば全部にピントが合う?それでも限界があった理由(ボケ・暗さ・回折)

写真撮影の世界では、「できるだけ多くの範囲にピントを合わせたいなら、絞ればよい」という考え方が長く常識とされてきました。

絞り(F値)を大きく設定することで被写界深度が深まり、手前から奥までピントが合って見える範囲が広がるためです。たとえば、F2.8のレンズをF16まで絞ると、被写界深度はおよそ5〜6倍に広がり、風景撮影などで効果的に見えることがあります。

しかし、実際には「絞ればすべてにピントが合う」というのは厳密には誤りであり、いくつかの物理的・光学的な限界が存在します。

暗くなるという根本的な問題

まず、絞りを絞るほど、レンズを通過する光の量が減少します。F値が1段上がるごとに光の量は半分になり、F2.8からF16まで絞ると、実に6段分=1/64の光量になります。

このため、露出を確保するにはシャッタースピードを遅くするか、ISO感度を上げる必要が生じます。

- シャッタースピードを遅くすれば、三脚を使わない限り手ブレや被写体ブレが発生しやすくなります。

- ISO感度を上げれば、デジタルノイズが増加し、特に暗部の階調再現が損なわれます。

つまり、「全体にピントを合わせたい」と思っても、光量不足によって画質を犠牲にせざるを得ないというジレンマが生まれるのです。

この現象は光学的に避けられない性質であり、どんな高性能レンズを使っても、絞りを絞る限り光量の損失は避けられません。

回折による解像度低下

もうひとつの問題が「回折(かいせつ)」です。これは、光が絞りの開口部の縁で波として広がる現象であり、レンズのF値を上げすぎると、細部の像が滲んだように甘くなってしまう現象です。

光の波長(およそ0.55μm前後の可視光)に対して開口径が小さくなると、センサー上で発生する光の干渉パターン(エアリーディスク)が広がり、隣り合う画素間で像が干渉してしまいます。

その結果、理論的には被写界深度が深くなっているはずでも、実際には細部の解像感が低下します。特に高画素センサーでは、1画素あたりのサイズが3〜4μm程度しかないため、F11〜F16を超えると回折の影響が顕著になります。

このため、カメラメーカーの多くは「風景撮影に最適なF値はF8前後」と推奨しており、これ以上の絞り込みは「解像度と被写界深度のトレードオフ」になることが知られています(出典:Canon株式会社 技術情報「レンズ共通特長」

ボケ表現の自由度が下がる

また、F値を上げるほど背景ボケが減少し、被写体を際立たせる効果も弱まります。

絞りを開けた状態(浅い被写界深度)では、被写体と背景の距離差を強調することができますが、絞り込むことで背景も明瞭に写り、立体感の少ない平板な印象の写真になります。

このため、ポートレートや商品写真の分野では、全体にピントを合わせることよりも「意図的なボケ表現」に価値を置くケースが多いのです。

したがって、絞り込みは万能ではなく、

- 明るさの低下

- 回折による解像度の限界

- 表現の制約

といった問題を抱えています。

すべてにピントを合わせる カメラレンズの研究は、この「絞ればなんとかなる」という従来のアプローチを根本から見直し、光量を犠牲にせず、回折を抑え、しかも自由にフォーカスを制御するという新しい方向へと進んでいます。

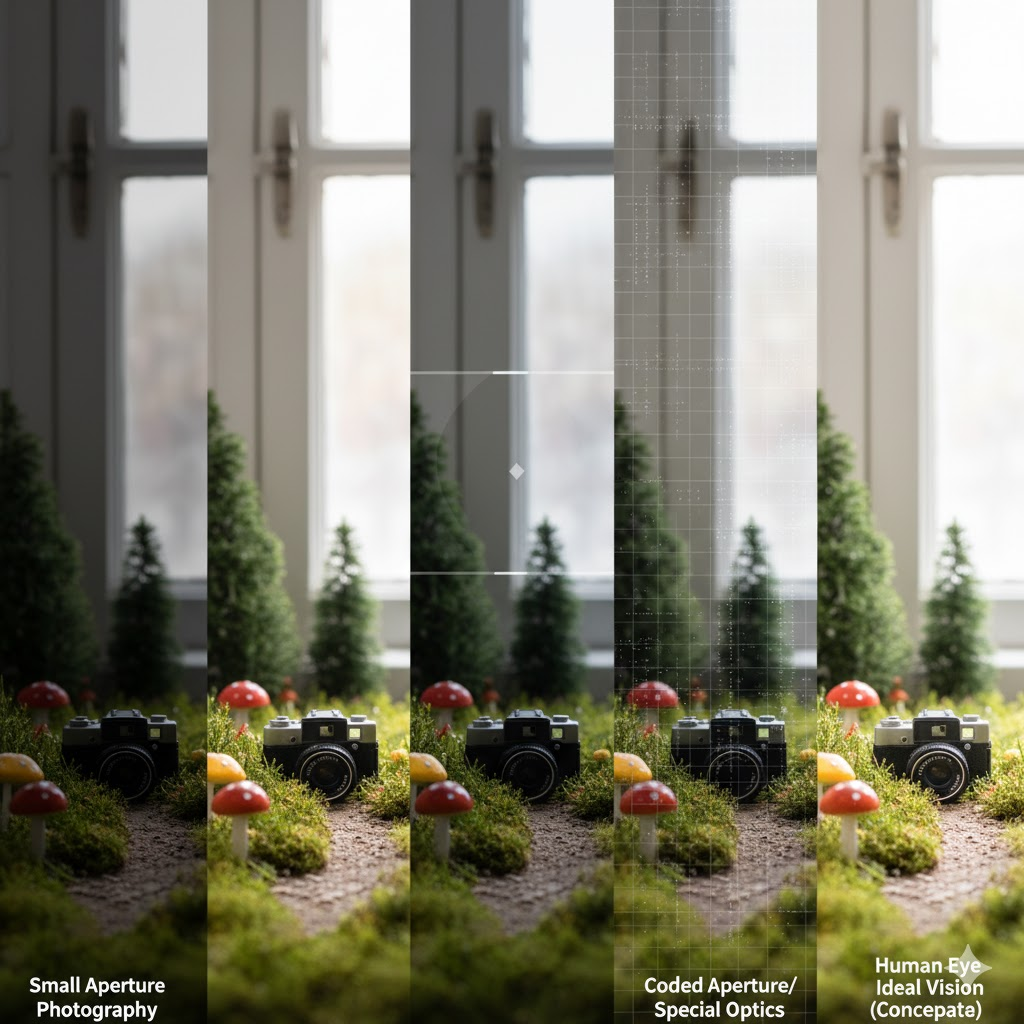

これまでの手法(小絞り・フォーカススタック・ライトフィールド)との違い

すべてにピントを合わせた写真を得るために、過去にはさまざまな手法が考案されてきました。

どの方法にも一長一短があり、目的や被写体の動きによって適否が大きく変わります。ここでは代表的な手法を比較しながら、それぞれの限界と、最新技術がどのようにその壁を越えようとしているのかを整理します。

| 手法 | 特徴 | 主なメリット | 主なデメリット |

|---|---|---|---|

| 小絞り撮影 | 絞り値を大きくして被写界深度を拡大 | 一枚で完結、特別な装置が不要 | 暗くなる、回折による解像度低下 |

| フォーカススタック | ピント位置を変えた複数枚を合成 | 高い解像度で広い被写界深度を確保 | 多枚数撮影が必要、動く被写体に不向き |

| ライトフィールドカメラ | 光線の方向も同時に記録 | 撮影後にピント位置を変更可能 | 空間解像度が低下、装置が高価 |

| コード化絞り・特殊光学系 | 絞りやレンズに特殊パターンを導入 | 後処理でボケを補正できる | ノイズや偽像が出やすく、演算負荷が大きい |

フォーカススタックの仕組みと限界

フォーカススタックは、マクロ撮影や製品撮影の現場で広く使われてきた手法です。

異なるピント位置で複数枚の画像を撮影し、それぞれの「最もシャープな領域」だけを合成して一枚の画像にまとめます。

PhotoshopやHelicon Focusなどのソフトウェアで合成処理が可能ですが、被写体が動くと境界部分にズレやゴーストが生じやすく、風景や生き物などには不向きです。

また、数十枚の撮影と合成が必要なため、処理時間が長く、リアルタイム性に欠けるのも難点です。

これに対し、すべてにピントを合わせる カメラレンズでは、撮影時点で光学的に全域にピントを合わせるため、そもそも多枚数撮影や後処理を必要としません。

ライトフィールドカメラとの比較

ライトフィールドカメラ(代表例:Lytro社)は、レンズとセンサーの間にマイクロレンズアレイを配置し、光線の方向情報を同時に記録します。

撮影後にピント位置を任意に変えられるという革新的な機能を持ちましたが、その代償として空間解像度が低下するという欠点を抱えていました。

たとえば、センサーが1600万画素であっても、方向情報を記録するために画素が分割され、最終的な出力画像は200万画素前後にとどまる場合もありました。

新しいアプローチ:光学的最適化

今回の研究で提案されているすべてにピントを合わせる カメラレンズは、これらの問題を根本的に解決する方向へ進んでいます。

主な特徴は次の通りです。

- レンズ自体をプログラム制御し、撮影時から各画素の焦点を最適化する

- 後処理でボケを補正するのではなく、光学的に最初からシャープな像を結ぶ

- フォーカススタックのように数十枚の撮影を必要とせず、1〜2枚の撮影で完結する

言い換えれば、これまでの「たくさん撮って後で計算する」発想から、「撮る瞬間に光学的に最適化する」方向へとパラダイムシフトが起きているのです。

この発想は、撮影装置の設計そのものを見直す契機となり、将来的には産業用ビジョンシステムや自動運転カメラにも応用されると期待されています。

すべてにピントを合わせる カメラレンズ研究の最前線

●このセクションで扱うトピック

- 発想の転換:「1つの焦点面」ではなく「好きな形のフォーカル面」を作る ローマン/アルバレスレンズとは?2枚のキュービックレンズで焦点を変える仕組み

- 光学 × アルゴリズムのハイブリッド「コンピュテーショナルレンズ」とは

- 各エリアごとに最適なピントを探す「空間的なコントラストAF(CDAF)」 デュアルピクセルを活用して一気に深度マップを推定する「空間的PDAF」

- オプティカルに「オールインフォーカス」を実現するメリットと制約

- 写真だけじゃない:顕微鏡・自動運転・監視カメラへの応用可能性

- 背景だけボカす/細いワイヤだけ消す──自由自在なボケ表現のデモ例 なぜまだ製品化されていないのか?光量ロス・光学設計・専用センサーの課題

- すべてにピントを合わせる カメラレンズとレンズ設計の新しいカテゴリとしての意義と、今後の研究・実用化の展望

発想の転換:「1つの焦点面」ではなく「好きな形のフォーカル面」を作る ローマン/アルバレスレンズとは?2枚のキュービックレンズで焦点を変える仕組み

シーンのどこにピントを合わせるか、という発想から一歩進んで、「そもそも焦点面は平面である必要があるのか」という問いかけに踏み込んでいるのが、今回の研究の大きな特徴です。

手前の被写体はカメラに近い位置に、奥の被写体は遠い位置に存在している以上、本来はフォーカス面もそれに合わせて曲がっていてよいはずです。

もしレンズ側で、被写体の三次元形状に沿うような自由な曲面のフォーカル面を作ることができれば、手前から奥までを同時にシャープに写す、というこれまで夢物語だった状態に近づくことができます。

その発想を実現する鍵を握るのが、ローマンレンズやアルバレスレンズと呼ばれる可変焦点レンズの仕組みです。

これらは、キュービック(立方)な位相プロファイルを持つ二つの光学素子を、光軸に対してわずかに平行移動させて重ね合わせることで、実効的なレンズの焦点距離を連続的に変えられるようにしたものです。

キュービック位相板一枚の位相分布は、おおまかに「x³」に比例する形をしています。

この板をもう一枚用意し、逆向きのカーブを持つように設計した上で、二枚を少しずつスライドさせながら重ねると、二つのキュービック成分が打ち消し合いつつ、新たに二次関数的な位相分布が生じます。

この二次成分こそが通常のレンズと同じ働きを担い、その係数の大きさが「焦点距離」に相当します。つまり、スライド量を変えるだけで、フォーカス位置を滑らかに変化させられるわけです。

従来のアルバレスレンズなどは、レンズ全体の焦点を一括で変える用途で使われてきました。たとえば視力補正や拡大鏡などで、機械的に素子をスライドさせることで焦点調整を行う、といった使い方です。

今回の研究では、この発想を一気に拡張し、「レンズ全体を一律にスライドさせる」のではなく、「画面上の位置ごとにスライド量を変える」ために、空間光変調器(Spatial Light Modulator:SLM)が組み込まれています。

SLMは、画面の各ピクセルごとに光の位相を変調できるデバイスです。ここにアルバレスレンズ相当のパターンを表示することで、実質的に「画素ごとに異なるキュービック位相板を用意している」のと同じ状態を作り出せます。

SLMに表示されるパターンを更新すると、画面のある位置では二枚の位相板のスライド量が大きくなり、別の位置ではほとんどスライドしない、といった状態を作れます。

結果として、画面上の位置ごとに異なる焦点距離を持たせることができ、「ここは手前にピント」「ここは無限遠」「ここだけ中距離」といった命令を、ほぼ画素単位の細かさで与えられるようになります。

要するに、レンズを物理的に動かさなくても、光学的に「好きな形のフォーカル面」をプログラムできるようにした、というイメージです。

山なりの奥行きを持つ被写体なら山なりの焦点面を、人物と背景が離れているシーンなら人物に沿ったフォーカル面を、といった具合に、被写体の三次元構造に合わせてフォーカス面を自由に設計できるポテンシャルがあります。

この可変フォーカル面の考え方が、すべてにピントを合わせる カメラレンズの光学的な基盤となっており、従来の「一枚の平面しか合焦できない」というレンズ設計の前提を大きく揺さぶるものになっています(出典:Carnegie Mellon University「Spatially-Varying Autofocus」)。

光学 × アルゴリズムのハイブリッド「コンピュテーショナルレンズ」ととは

コンピュテーショナルレンズという言葉は、単に「レンズ+画像処理」という意味にとどまらず、「光学系そのものがアルゴリズムによって能動的に制御されるカメラ」を指す概念として使われています。

今回の研究で提案されているコンピュテーショナルレンズも、純粋な光学だけでもなく、完全なデジタル後処理だけでもなく、その中間に位置する新しいカテゴリの技術です。

全体の仕組みを整理すると、次のようなサイクルで動作しています。

まず、コンピュテーショナルレンズの光学系が、SLMとキュービック位相板によって空間的に変化する焦点特性を実現します。

ここでは、あらかじめ設定された初期パターンに基づいて、「おおよその」フォーカス面が作られており、シーン全体を観察するための最初の一枚を撮影します。

次に、その撮影結果(通常の画像、あるいはデュアルピクセルセンサーによって得られる左右のサブピクセル画像)から、シーンの奥行き分布、つまり深度マップが推定されます。

このステップでは、コントラストの変化を利用する手法(CDAF的アプローチ)や、デュアルピクセル間の視差から距離を推定する手法(PDAF的アプローチ)が用いられます。

深度マップは、「画面上のこの位置にはどれくらいの距離に被写体があるか」を表したもので、これが次の制御の鍵になります。

続いて、その深度マップに基づいて、次のフレームで必要になるフォーカル面の形が計算されます。

たとえば、ある画素が1m先の被写体を見ており、別の画素が5m先を見ていると分かれば、それぞれの画素に対して「どれくらい焦点距離を変えればよいか」という指示量を計算し、それをSLMに表示する位相パターンに変換します。

SLMのパターンが更新されると、レンズの特性そのものが変化し、次に撮る画像ではより多くの部分が正しくフォーカスされるようになります。

このサイクルを繰り返すことで、シーン全体をほぼシャープに捉えたオールインフォーカス画像に収束していきます。

重要なのは、この一連の流れが、単に「撮った画像を後からソフトでいじる」のではなく、「光を集める段階から計算が関わっている」という点です。

光学系とアルゴリズムが分離しているのではなく、アルゴリズムが光学系の一部として組み込まれている、と捉えるとイメージしやすくなります。

このアプローチには、次のような利点があります。

- 大がかりなデコンボリューション処理が不要になる

レンズ側でピントを合わせてしまうため、後処理で強いシャープネスやボケ補正を行う必要がありません。

その結果、ノイズの増幅や偽輪郭の発生を抑えやすくなります。 - 一度深度マップを得れば、その後の追従が効率的になる

シーンが大きく変わらない限り、前のフレームの深度情報を活用して、次のフォーカス制御を素早く行えます。

動きのあるシーンに対しても、毎フレームゼロから探索するよりも効率よくフォーカスを維持できます。 - 用途に応じた「レンズ特性の切り替え」が理論的に可能

ソフトウェア側で指定するパラメータを変えれば、「全域をシャープにするモード」「前景だけをシャープにし背景をボカすモード」「特定の距離帯だけを強調するモード」など、レンズの性格そのものを切り替えることも視野に入ります。

このような背景から、コンピュテーショナルレンズは、従来の「固定の光学系+汎用画像処理」というカメラの構成とは一線を画す存在として注目されています。

今後、計算資源の小型化や高速化が進めば、こうした光学×アルゴリズム一体型のカメラは、専門用途だけでなく一般向けデバイスにも広がっていく可能性があります。

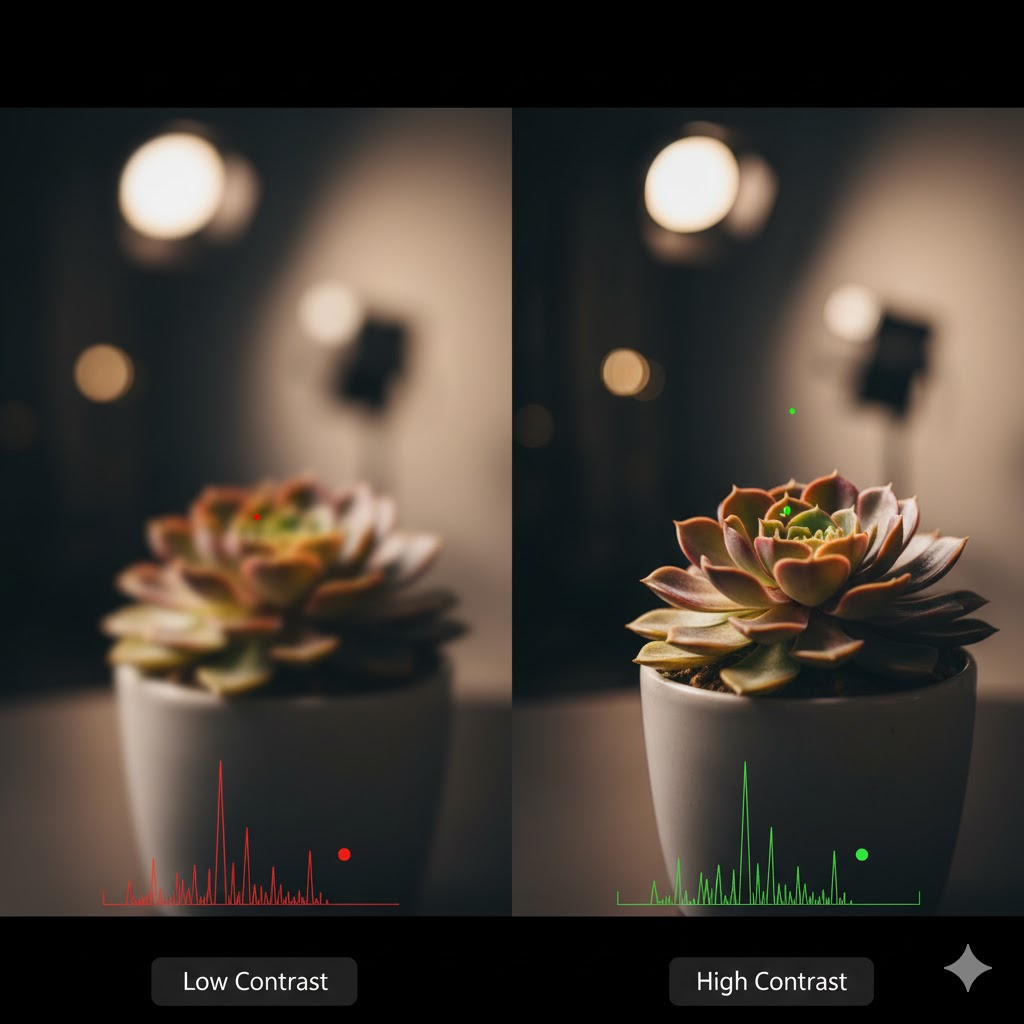

各エリアごとに最適なピントを探す「空間的なコントラストAF(CDAF)」 デュアルピクセルを活用して一気に深度マップを推定する「空間的PDAF」

最新の研究では、すべてにピントを合わせる カメラレンズの実現に向けて、フォーカスを自動的かつ空間的に最適化する二つの手法が組み合わされています。

一つは、画像全体を解析して領域ごとにピントを調整する「空間的なコントラストAF(Contrast Detection Auto Focus: CDAF)」、もう一つは、デュアルピクセル技術を利用して瞬時に奥行きを推定する「空間的PDAF(Phase Detection Auto Focus)」です。

この二つの方式が協調的に動作することで、動きのある被写体でも、空間的に複雑なシーンでも、すべての領域にピントを合わせる高度なフォーカス制御が可能になります。

空間的なコントラストAF(CDAF)

コントラストAFは、デジタルカメラやスマートフォンに広く搭載されている方式で、画像のコントラスト(明暗の差)が最も高くなる焦点位置を探索する仕組みです。

従来のCDAFは、画面中央や選択された一点のみを解析して、レンズを前後に移動させながらコントラストが最大になる位置を見つけるというものでした。

これに対して、「空間的なCDAF」はその考え方を全画面に拡張しています。

具体的には、撮影画像を数百から数千単位の小さなブロック(スーパーピクセル)に分割し、それぞれの領域に対して独立にフォーカス評価を行います。

各領域でレンズを微調整し、コントラストが最も高くなる深度を求めることで、画面全体にわたる最適フォーカス分布――すなわち「深度マップ(Depth Map)」が生成されます。

この深度マップを用いることで、次の撮影ではSLM(空間光変調器)に最適な位相パターンを表示し、各領域に対応したフォーカル面を再構成できるようになります。

この手法の特筆すべき点は、単に「全体にピントを合わせる」だけでなく、領域ごとに異なる被写界深度を持たせることができるという柔軟性です。

たとえば、被写体の中央部分は浅い被写界深度で立体感を出し、周囲の背景は広い被写界深度でディテールを保持するといった制御も理論上可能になります。

また、CDAFはコントラスト信号そのものを基準にするため、被写体の形状や明るさに左右されにくく、精密な微調整が可能です。

欠点としては、複数枚の撮影と解析を必要とするため、動く被写体では処理の遅延が発生しやすいという点があります。

この弱点を補うのが、次に紹介する「空間的PDAF」です。

空間的PDAF(デュアルピクセルを活用)

空間的PDAF(Phase Detection Auto Focus)は、センサーの各画素に内蔵された二つのフォトダイオードを利用し、光の位相差(視差)から被写体の距離を推定する方式です。

デュアルピクセルセンサーは、1画素の下に左右対称の2つの受光部を持ち、レンズの両側から入射する光をそれぞれ独立して受け取ります。

ピントが合っていない状態では、左右の光像にズレが生じます。このズレ量(位相差)を測定することで、フォーカスが前ピンか後ピンか、そしてどれだけずれているかを一瞬で判断できます。

この方式の優れている点は、1枚の撮影で全画面の深度情報を得られることです。

研究では、撮影画像を意味的な単位(セマンティックセグメンテーション)で分割し、それぞれの領域ごとにデュアルピクセルの視差データを解析します。

これにより、空間的な深度マップを高速に生成でき、被写体の動きにも対応できるのです。

たとえば、人物が手前に移動しても、PDAFはフレームごとにピクセル単位で奥行きを再計算し、レンズ制御系にリアルタイムでフィードバックします。

これによって、従来の「レンズを前後に動かしてフォーカスを探す」という手順を省略でき、瞬時にピント位置を合わせることが可能になります。

この技術はすでにCanon、Sony、Samsungなどのカメラセンサーで採用されており、位相差AFの精度と速度が飛躍的に向上していることが報告されています。

空間的CDAFとPDAFの組み合わせによる統合制御

空間的CDAFとPDAFは、それぞれの長所と短所を補い合う関係にあります。

CDAFは精度が高く、どんな被写体にも適応できる一方で、探索時間がかかる傾向があります。

一方、PDAFは高速で、動きのある被写体にも対応しやすいものの、コントラストの低い領域や特殊な光条件では誤差が発生することがあります。

研究では、この二つを並列的に活用するハイブリッド制御が採用されています。

まずPDAFが全体の深度マップを高速に予測し、その情報をもとにCDAFが微調整を行います。

これにより、被写体が動いても、全画面にわたって正確なフォーカスを維持することが可能になります。

また、SLMを通じたフォーカル面のリアルタイム変形と組み合わせることで、「撮るたびにレンズを動かさずにフォーカス面を再設計する」ことが実現されています。

このような仕組みにより、すべてにピントを合わせる カメラレンズは、静止した風景から動的なシーンまで幅広く対応できるようになっています。

人間の眼のように、シーン全体を認識しながら焦点を瞬時に再配置する──そんな生体視覚的なフォーカス制御に近い動作が、光学と計算の融合によって可能になりつつあるのです。

オプティカルに「オールインフォーカス」を実現するメリットと制約

「オールインフォーカス」とは、シーン全体にピントが合い、手前から奥までが均一にシャープに見える状態を指します。

これを光学的に直接実現することには、従来の撮影技術にはない多くの利点がありますが、同時に避けられない物理的・設計的制約も存在します。

光学的オールインフォーカスの主なメリット

- 情報の完全取得

従来のカメラでは、ピントの合っていない領域の情報はセンサー上で失われてしまい、後処理で復元するしかありません。

しかし光学的に全域にピントが合っていれば、最初から細部情報がセンサーに正確に記録されるため、解像感やテクスチャの再現性が著しく向上します。 - 後処理の簡略化

フォーカススタックやライトフィールドのような技術では、複数の画像を撮影・解析しなければなりません。

一方、オールインフォーカスレンズは、光学系の段階で最適化されているため、重いデコンボリューション処理を行う必要がなく、リアルタイム処理が容易になります。 - 応用範囲の拡大

顕微鏡観察、産業検査、自動運転カメラなど、精密な奥行き情報が求められる分野で大きな効果を発揮します。

特に動きのある対象を扱う場合、光学的オールインフォーカスの利点は非常に大きいといえます。

現在の課題と制約

とはいえ、この技術にはいくつかの実用化上の課題があります。

- 光量ロス

SLMやビームスプリッタなどの光学素子を複数通過することで、入射光の30〜50%が失われるとされます。

この光量損失は、暗所や高速シャッター撮影において致命的な制約となる場合があります。 - 光学系の複雑化とコスト

フォーカル面を動的に制御するための光学設計は高度であり、構造の大型化や製造コストの増加を招きます。

また、温度変化や振動に対する安定性の確保も課題です。 - 専用センサーへの依存

デュアルピクセル方式など特定のセンサー構造を必要とするため、既存の汎用カメラシステムにはそのまま組み込めません。

高精度な同期制御が求められるため、ソフトウェアとハードウェアの協調設計も不可欠です。

今後の展望

研究プロトタイプでは、すでに「リアルタイム・オールインフォーカス撮影」が実現しており、解像度1920×1080ピクセル、60fpsでの動作が報告されています。

今後は、光量ロスを低減する高効率SLMの開発や、低消費電力なフォーカス制御アルゴリズムの改良により、商用カメラへの応用が期待されています。

これらを踏まえると、光学的なオールインフォーカス技術は、単なる研究段階を超え、次世代の「認識指向型カメラシステム」としての実用化が見えてきています。

ただし現時点では、まだ一般的なカメラ製品に搭載されるにはコスト・構造・光効率の面で課題が多く、研究段階に留まっているといえるでしょう。

写真だけじゃない:顕微鏡・自動運転・監視カメラへの応用可能性

すべてにピントを合わせる カメラレンズの技術は、一見すると風景写真やスナップのための夢のレンズのように思われますが、実際に大きなインパクトを持ち得るのは、むしろ産業や科学、インフラといった分野です。

「一枚の画像に、できるだけ多くの正確な情報を載せる」というニーズが強い領域ほど、この技術の価値は高まります。

まず顕微鏡分野を見てみると、厚みのあるサンプルを観察する場面では、現在でもフォーカス位置を少しずつ変えながら多数枚を撮影し、それらを合成して全層にピントが合った画像(いわゆるZスタック)を作る方法が一般的です。

この手法は高解像度な観察が可能な一方で、

- 何十枚もの画像を撮るため撮影時間が長くなる

- 生きている細胞や微生物の場合、撮影中に動いてしまいゴーストが発生する

- 合成処理に計算資源と時間が必要になる

といった課題があります。

もし一度の撮影で、サンプルの全層にピントが合うようなフォーカル面を光学的に作り出せれば、観察の効率が大きく向上しますし、動きによるブレやズレの問題も軽減できます。さらに、深度マップも同時に取得できれば、「どの層に何が存在するのか」を立体的に解析することも容易になります。

自動運転や高度な運転支援システムの分野では、カメラは「風景を記録する」ためではなく「周囲環境を認識する」ために使われます。

手前の車両や歩行者、少し離れた信号機、さらに遠くの標識や建物など、さまざまな距離にある対象を同時に見分ける必要があります。特定の距離だけにピントが合っている状態では、

- 遠くの歩行者がぼけて検出精度が下がる

- 路面の小さな障害物を見落としやすくなる

- 信号機や標識の文字認識が不安定になる

といったリスクが生じます。

シーン全体にわたってシャープな情報が得られるカメラであれば、物体検出・セグメンテーション・距離推定といった画像認識アルゴリズムに入力されるデータの品質が高まります。これはそのまま、検出精度や安全性の向上につながります。

監視カメラの分野でも事情は似ています。広い駐車場や工場の構内などでは、カメラから数メートルの範囲にいる人物と、遠くの出入口付近の車両や人の動きのどちらも見逃すことができません。

従来は、ある程度画角を分けて複数台のカメラを配置したり、パン・チルト・ズームによって注視するポイントを切り替えたりしてきました。

すべてにピントを合わせる カメラレンズのように、画面全域で高い解像感を維持できる仕組みが整えば、

- カメラ台数の削減

- デジタルズームでも識別可能な画質の確保

- 過去映像をさかのぼって解析する際の精度向上

といった効果が期待できます。

さらに、産業用マシンビジョンの世界でも、この技術は大きな意味を持ちます。

電子基板や立体的な部品の検査では、部品の高さ方向のズレや微小な傷を検出する必要がありますが、フォーカスが一部にしか合っていない画像では、奥行き方向の情報が失われがちです。

オールインフォーカス画像と深度情報を同時に扱えるようになれば、

- 検査対象の三次元的な寸法測定

- ロボットアームによるピッキング位置の高精度な決定

- カメラの位置や角度に依存しない安定した検査フロー

など、製造ラインや物流現場での自動化・省人化に大きく寄与すると考えられます。

このように、すべてにピントを合わせる カメラレンズは、写真表現のための技術を超えて、「見て理解する」「測って判断する」といった認識・計測の基盤技術としての可能性を持っています。

今後は、光学系そのものの改良に加えて、用途別に最適化されたソフトウェアやAI認識モデルとの組み合わせが進むことで、顕微鏡、自動運転、監視カメラ、マシンビジョンなど、さまざまな現場への実装が検討されていくと考えられます。

背景だけボカす/細いワイヤだけ消す──自由自在なボケ表現のデモ例 なぜまだ製品化されていないのか?光量ロス・光学設計・専用センサーの課題

この技術の興味深い点は、「すべてにピントを合わせられる」だけにとどまらず、「どこをボカすかを後から自由に選べる」ような表現面での応用も視野に入っていることです。

研究デモでは、まずシーン全体の深度マップを取得し、その上で特定の距離帯に対してだけ意図的にボケを加える、という使い方が紹介されています。

例えば、次のような応用が示されています。

- 背景だけボカして主役の人物や物体を立ち上がらせる

- 手前にある細いワイヤやフェンスだけを大きくボカし、ほとんど見えなくしてしまう

これまでのレンズでは、ボケ量は基本的に「絞り値」と「焦点距離」と「被写体距離」の組み合わせで一様に決まり、画面の場所ごとにボケ具合を変えることはできませんでした。

それに対して、可変フォーカル面と深度マップを組み合わせたシステムでは、「距離ごとに異なるボケ量を設計する」「距離に加え、画面位置ごとにボケ量を変える」といった柔軟な制御が可能になります。

これは、ソフトウェアによる背景ぼかし(ポートレートモード)のように、後処理で擬似的にボケを作る方法とも異なります。

光学的にフォーカス面を操作しているため、

- ボケの輪郭やボケ内のハイライト(いわゆる玉ボケ)の自然さを保ちやすい

- 被写体と背景の境界で、マスクの甘さによる不自然なにじみが出にくい

- もともとピントが合っている状態から意図的にボカすため、細部表現とボケの切り替えが高品位

といったメリットが期待できます。

一方で、「それだけ魅力的なら、なぜまだ市販カメラに搭載されていないのか」という疑問は当然生じます。

主な技術的・実用的な課題として、次のような点が挙げられます。

- 光量ロスが大きく、実用的な感度を確保しにくい

- SLMやビームスプリッタは偏光依存の素子であることが多く、理論的にも通過光の一部しか活用できません。

- プロトタイプでは、入射光のうちセンサーに到達するのが1/4〜1/8程度にとどまるケースも報告されており、暗所撮影や高速撮影では厳しい制約になります。

- 複雑な光学設計と実装コスト

- フォーカル面を自由に変形させるための光学レイアウトは多段構成になりがちで、一般的な交換レンズと比べてサイズ・重量・コストが増加します。

- 温度変化や振動に対する安定性、長期的なキャリブレーション維持といった実務上の要件もクリアする必要があります。

- 専用センサーや高性能処理系への依存

- デュアルピクセルなどの専用センサー構造が前提になるケースが多く、既存のイメージセンサーをそのまま流用することが難しい場合があります。

- 深度マップ推定やSLMパターン更新を高フレームレートで行うには、GPUなどの高性能な処理系が必要であり、消費電力や発熱も課題になります。

- ソフトウェアとハードウェアの密結合設計が必要

- 光学系、センサー、制御アルゴリズムが強く結びついているため、どれか一つだけを独立して改良するのが難しく、製品化までの開発負荷が高くなりやすいです。

こうした理由から、現時点では「研究用プロトタイプ」としては高い完成度を持ちながらも、一般ユーザー向けの市販カメラにそのまま搭載する段階には至っていないと考えられます。

ただし、光学素子の小型化・高効率化や、新しい位相変調デバイス(液晶SLMに代わるMEMSミラーやメタサーフェス光学素子など)の研究も進んでおり、これらが実用レベルに達すれば、状況は大きく変わる可能性があります。

将来的には、

- プロ用途のシネマカメラや産業用カメラへの限定的な搭載

- 顕微鏡や測定装置への組み込み

- AR/VRデバイス向けの軽量な計算光学系としての採用

といった形で、すべてにピントを合わせる カメラレンズ技術が徐々に実環境へ浸透していくシナリオも十分に考えられます。

いまはまだ黎明期ですが、「自由自在なボケとオールインフォーカスを両立できる光学系」というコンセプトは、写真表現と機械認識の両面から、今後も注目され続けると考えられます。

すべてにピントを合わせる カメラレンズとレンズ設計の新しいカテゴリとしての意義と、今後の研究・実用化の展望

最後に、この記事で見てきたポイントを整理しながら、すべてにピントを合わせる カメラレンズがレンズ設計の新しいカテゴリとして持つ意味と、今後の展望をまとめます。

- すべてにピントを合わせる カメラレンズは焦点面を自由に設計するという発想の転換である

- 従来レンズの前提だった一枚の平面へのフォーカス制約を乗り越えようとしている

- 小絞り撮影だけでは回折や暗さによる画質低下を避けられないことが改めて明確になった

- フォーカススタックやライトフィールドは多枚数撮影や解像度低下というトレードオフを抱えている

- ローマンやアルバレスレンズの原理を応用した可変焦点光学系が中核技術となっている

- 空間光変調器とキュービック位相板を組み合わせることで画素単位に近いフォーカス制御が可能になった

- 空間的なコントラストAFは領域ごとに最適なピントを探索するアルゴリズムとして機能する

- 空間的PDAFはデュアルピクセル情報から深度マップを高速に推定する役割を担っている

- オールインフォーカスを光学的に実現することで後処理に依存しない高い解像感が期待できる

- 顕微鏡や自動運転や監視カメラなど産業・科学分野での応用可能性が高い技術である

- 背景だけボカす細いワイヤだけ消すといった自由度の高いボケ表現も理論的には実現可能になっている

- 現状では光量ロスや光学設計の複雑さ専用センサー依存などが実用化を妨げる大きな要因となっている

- 光学素子やセンサーや制御系の進歩がこれらの課題を緩和すれば製品レベルへの応用も見込まれる

- 今後は写真表現だけでなく機械視覚や計測分野のニーズも巻き込みながら研究が進むと考えられる

- すべてにピントを合わせる カメラレンズはコンピュテーショナルレンズという新しいレンズ設計カテゴリを代表する存在になりつつある

コメント